- robots.txtの基本的な仕組みと記述方法

robots.txtは検索エンジンクローラーが最初に確認するファイルで、User-agent、Disallow、Allow、Sitemapなどのディレクティブを使用してクロール制御を行います。ワイルドカードやパターンマッチングを活用することで、柔軟かつ効率的なアクセス制御が可能になります。

- SEO効果を最大化するrobots.txtの設定ポイント

クロールバジェットの最適化のため、管理画面や重複コンテンツなど価値の低いページへのアクセスを制限し、重要なページに検索エンジンのリソースを集中させることが重要です。サイトマップとの連携やモバイルファーストインデックスへの配慮も、SEO効果向上に不可欠な要素となります。

- よくある設定ミスとその対処法

全サイトブロック設定やパス記述の誤り、ファイルの配置場所ミスなど、robots.txtには多くの設定ミスのパターンがあります。Google Search Consoleのrobots.txtテスター機能を活用して定期的に動作確認を行い、意図した通りにクロール制御が機能しているかを検証することが重要です。

robots.txtは、検索エンジンのクローラーに対してサイト内のページやディレクトリへのアクセス制御を行う重要なファイルです。適切なrobots.txtの設定はSEO対策において欠かせない要素となっており、間違った設定をしてしまうとサイト全体のインデックスに悪影響を与える可能性があります。本記事では、SEO効果を最大化するrobots.txtの書き方から、よくある設定ミスまで詳しく解説します。正しい知識を身につけて、検索エンジンに適切にサイトを認識してもらいましょう。

robots.txtとは何か

robots.txtの基本的な仕組み

robots.txtは検索エンジンクローラーが最初に確認するファイルであり、サイト全体のクロール方針を決定する重要な役割を担っています。クローラーがウェブサイトにアクセスする際、まず「http://example.com/robots.txt」というURLでこのファイルを探し、記述された指示に従ってクロール作業を進めます。

robots.txtファイルは、特定のユーザーエージェント(クローラーの種類)に対して、どのディレクトリやファイルへのアクセスを許可または拒否するかを定義します。ただし、この指示は強制力を持つものではなく、あくまでも「お願い」という性質のものです。

SEO対策における重要性

SEO対策の観点から見ると、robots.txtはクローラーのリソースを効率的に配分し、重要なページを優先的にインデックスしてもらうための戦略的ツールとして活用できます。不要なページへのクロールを制限することで、検索エンジンが本当に重要なコンテンツに集中できるようになります。

また、robots.txtを適切に設定することで、サーバーの負荷軽減やクロールバジェットの最適化にも寄与します。特に大規模なウェブサイトでは、この効果がより顕著に現れるとされています。

検索エンジンクローラーとの関係

主要な検索エンジンクローラーは、robots.txtの指示を尊重してクロール作業を行います。Googlebot、Bingbot、Yahoo! Slurpなど、それぞれのクローラーに対して個別の指示を出すことも可能です。

クローラーはrobots.txtを24時間に1回程度の頻度で確認するとされており、ファイルの更新が反映されるまでには一定の時間がかかることを理解しておく必要があります。

robots.txtはSEOの基礎となるファイルですから、正しく理解して設定することが大切ですね。

robots.txtの記述方法と基本構文

基本的なディレクティブの種類

robots.txtで使用される主要なディレクティブは以下の通りです。User-agentディレクティブは対象となるクローラーを指定し、DisallowとAllowディレクティブでアクセス制御を行います。

| ディレクティブ | 用途 | 記述例 |

|---|---|---|

| User-agent | 対象クローラーの指定 | User-agent: Googlebot |

| Disallow | アクセス禁止の指定 | Disallow: /admin/ |

| Allow | アクセス許可の指定 | Allow: /public/ |

| Sitemap | サイトマップの場所指定 | Sitemap: https://example.com/sitemap.xml |

実践的な記述例

実際のrobots.txtファイルの記述例を以下に示します。各ディレクティブの組み合わせにより、柔軟なクロール制御が可能になります。

基本的な記述例:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://example.com/sitemap.xml

この例では、すべてのクローラーに対してWordPressの管理画面やシステムファイルへのアクセスを制限しつつ、AJAX機能に必要なファイルは例外的に許可しています。

ワイルドカードとパターンマッチング

robots.txtではワイルドカード(*)とドル記号($)を使用したパターンマッチングが可能で、より柔軟な制御ができます。アスタリスクは任意の文字列を表し、ドル記号はURLの末尾を示します。

例えば、「Disallow: /*.pdf$」と記述することで、すべてのPDFファイルへのアクセスを制限できます。また、「Disallow: /search?*」により、検索結果ページのクロールを防ぐことが可能です。

コメントと空行の活用

robots.txtファイルでは、「#」記号を使用してコメントを記述できます。ファイルの可読性を向上させ、設定の意図を明確にするために積極的に活用することをお勧めします。

また、空行を使用してグループを分けることで、視覚的に分かりやすいファイル構造を作ることができます。メンテナンス性の向上にも寄与するでしょう。

構文を正しく理解すれば、robots.txtで細かなクロール制御ができるようになります!

バクヤスAI 記事代行では、

高品質な記事を圧倒的なコストパフォーマンスでご提供!

SEO効果的なrobots.txt設定のポイント

クロールバジェットの最適化

クロールバジェットとは、検索エンジンが特定のサイトに割り当てるクロール作業の時間やリソースの総量を指します。限られたクロールバジェットを効率的に活用するため、価値の高いページに集中してもらう設定が重要になります。

不要なページへのクロールを制限することで、重要なコンテンツページや新しい記事により多くのクロール機会を割り当てることができます。特に、ECサイトやニュースサイトなど、大量のページを持つウェブサイトでは、この効果が顕著に現れるとされています。

制限すべきページの種類

SEO効果を高めるために制限すべきページには、以下のような種類があります。これらのページは、通常、検索結果に表示される必要がないか、ユーザーにとって価値が低いとされています。

robots.txtで制限を検討すべきページ

- 管理画面やログインページ

- 重複コンテンツが含まれる検索結果ページ

- プライベートな画像やドキュメントファイル

- テスト環境やステージング環境のページ

- カート機能や決済プロセスのページ

サイトマップとの連携戦略

robots.txtファイル内でSitemapディレクティブを使用することで、検索エンジンにサイトマップの場所を明示できます。robots.txtとサイトマップを組み合わせることで、制限するページと積極的にインデックスしてほしいページを明確に分けることができます。

複数のサイトマップがある場合は、それぞれのサイトマップURLをrobots.txtに記載することが可能です。この方法により、検索エンジンに対してサイト構造をより詳細に伝えることができるでしょう。

モバイルとデスクトップの考慮点

現在の検索エンジンは、モバイルファーストインデックスを採用しているため、robots.txtの設定もモバイル環境を考慮して行う必要があります。特に、レスポンシブデザインでない場合は、モバイル専用ページとデスクトップページそれぞれに適した設定を検討することが重要です。

また、AMPページを提供している場合は、AMP用のクローラーに対する設定も併せて考慮する必要があります。適切な設定により、すべてのデバイスでのSEO効果を最大化できるでしょう。

戦略的なrobots.txtの設定で、SEO効果を大幅に向上させることができますよ。

バクヤスAI 記事代行では、高品質な記事を圧倒的なコストパフォーマンスでご提供!

バクヤスAI 記事代行では、SEOの専門知識と豊富な実績を持つ専任担当者が、キーワード選定からAIを活用した記事作成、人の目による品質チェック、効果測定までワンストップでご支援いたします。

ご興味のある方は、ぜひ資料をダウンロードして詳細をご確認ください。

サービス導入事例

株式会社ヤマダデンキ 様

生成AIの活用により、以前よりも幅広いキーワードで、迅速にコンテンツ作成をすることが可能になりました。

親身になって相談に乗ってくれるTechSuiteさんにより、とても助かっております。

▶バクヤスAI 記事代行導入事例を見る

よくある設定ミスと対処法

全サイトブロックの危険な記述

最も深刻な設定ミスの一つが、意図せずサイト全体をブロックしてしまうことです。「User-agent: * Disallow: /」という記述は、すべてのクローラーに対してサイト全体へのアクセスを禁止する危険な設定となります。

この設定が行われると、検索エンジンはサイトのどのページもクロールできなくなり、検索結果からサイトが完全に消えてしまう可能性があります。特に、開発環境から本番環境にファイルを移行する際に、この設定が残ってしまうケースが多く見られます。

パス記述の間違いパターン

パスの記述において、スラッシュの有無や記述方法の間違いも頻繁に発生する問題です。以下の表で、正しい記述と間違った記述を比較して確認できます。

| 意図する制限 | 正しい記述 | 間違った記述 |

|---|---|---|

| adminディレクトリ全体 | Disallow: /admin/ | Disallow: admin |

| 特定のファイル | Disallow: /secret.html | Disallow: secret.html |

| パラメータ付きURL | Disallow: /search?* | Disallow: /search? |

ファイルの場所とアクセス権限の問題

robots.txtファイルは、必ずサイトのルートディレクトリに配置する必要があります。サブディレクトリに配置されたrobots.txtファイルは、検索エンジンクローラーによって認識されません。

また、ファイルのアクセス権限が適切に設定されていない場合、クローラーがファイルを読み取れない問題も発生します。通常は644の権限を設定し、すべてのユーザーが読み取り可能な状態にしておく必要があります。

文字コードと改行コードのトラブル

robots.txtファイルの文字コードや改行コードの設定ミスも、認識されない原因となることがあります。UTF-8エンコーディングを使用し、改行コードはLF(Unix形式)を推奨します。

特に、Windowsのテキストエディターでファイルを作成した場合、CRLF改行コードやBOM付きUTF-8になっている可能性があるため、注意深く確認する必要があります。

設定ミスを防ぐチェック項目

robots.txt設定前の確認チェックリスト

- ファイルがルートディレクトリに配置されているか

- User-agentとDisallowの組み合わせが正しいか

- 全サイトブロック設定になっていないか

- パスの記述にスラッシュが適切に含まれているか

- ファイルのアクセス権限が644に設定されているか

- 文字コードがUTF-8になっているか

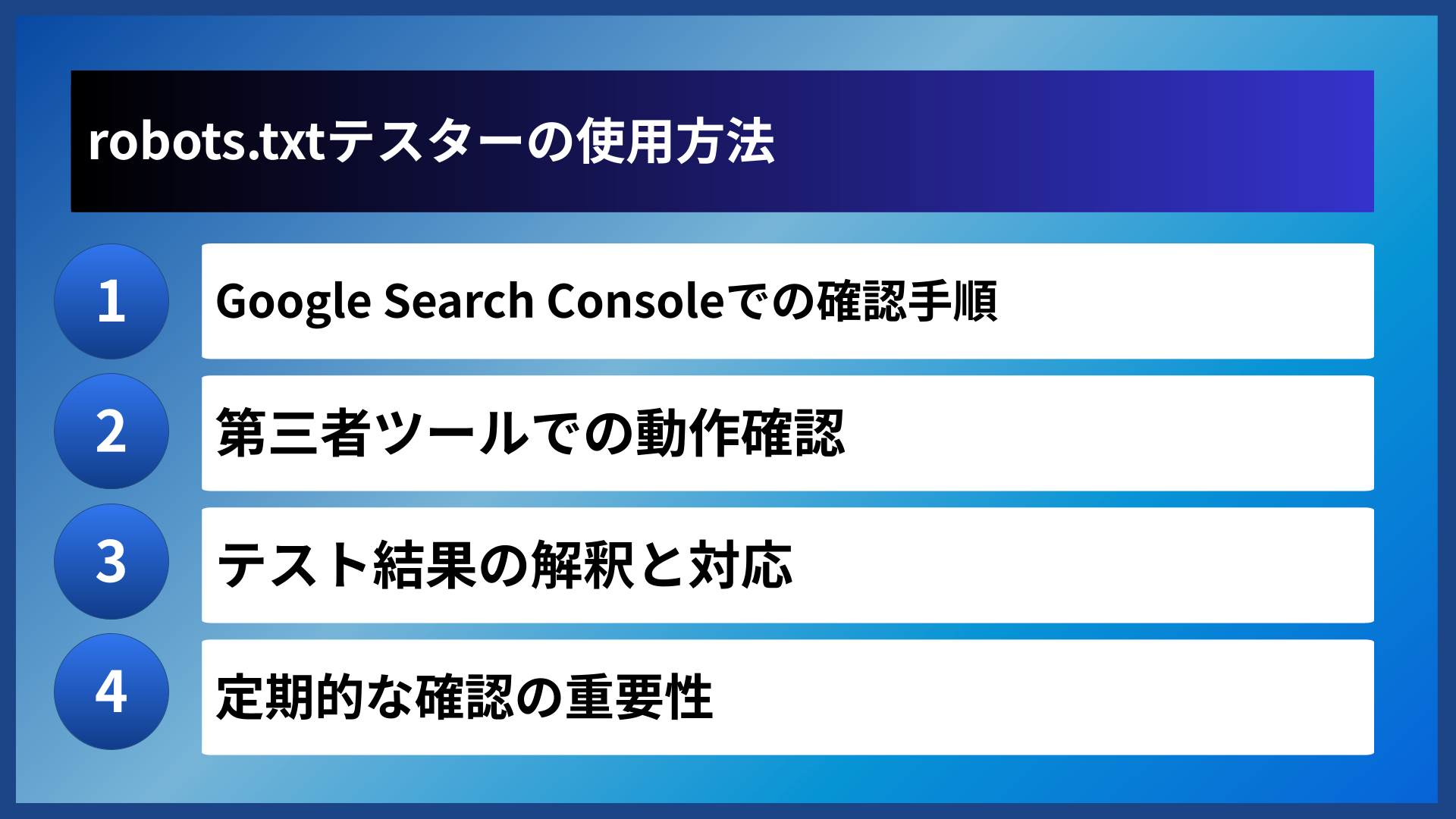

robots.txtテスターの使用方法

Google Search Consoleでの確認手順

Google Search Consoleでは、robots.txtテスター機能を通じて実際のGooglebotがどのようにrobots.txtファイルを解釈するかを確認できます。この機能により、設定ミスによる問題を事前に発見し、修正することが可能になります。

テスターを使用する際は、まずSearch Consoleにサイトを登録し、左側メニューの「クロール」セクションから「robots.txtテスター」を選択します。ここで現在のrobots.txtファイルの内容を確認し、特定のURLがブロックされているかどうかをテストできます。

第三者ツールでの動作確認

Google以外にも、robots.txtの動作を確認できる第三者ツールが複数存在します。これらのツールを併用することで、より包括的な検証を行うことができるでしょう。

オンラインのrobots.txtバリデーターでは、構文エラーや論理的な問題を検出できます。また、異なる検索エンジンクローラーの視点からファイルを解析するツールもあり、多面的な確認が可能です。

テスト結果の解釈と対応

テスト結果では、特定のURLがブロックされているか許可されているかが明確に表示されるため、意図した設定が正しく動作しているかを確認できます。もし予期しない結果が表示された場合は、robots.txtの記述を見直す必要があります。

テスト機能では、実際のクローラーと同じ解釈ロジックが使用されるため、本番環境での動作を正確に予測できます。修正が必要な場合は、テスターで何度も確認しながら最適な設定を見つけることができるでしょう。

定期的な確認の重要性

robots.txtファイルは一度設定すれば終わりではなく、サイト構造の変更やコンテンツの追加に応じて定期的な見直しが必要です。月に一度程度の頻度でテスターを使用し、設定が適切に機能しているかを確認することをお勧めします。

特に、新しいディレクトリの追加やサイトリニューアル後は、意図しないページがブロックされていないか、重要なページが正しくクロール可能かを慎重に確認する必要があります。

定期的なテストで、robots.txtの動作を確実に把握しておきましょう。

よくある質問

robots.txtに関してよく寄せられる質問とその回答をまとめました。

- robots.txtファイルがなくても問題ありませんか?

-

robots.txtファイルが存在しなくても、検索エンジンは通常通りサイトをクロールします。ただし、特定のページを制限したい場合や、サイトマップの場所を明示したい場合には、robots.txtを設置することをお勧めします。大規模サイトでは、クロールバジェットの最適化にも役立ちます。

- robots.txtで禁止したページが検索結果に表示されることはありますか?

-

robots.txtでDisallowを指定したページでも、他のサイトからリンクされている場合などは検索結果に表示される可能性があります。完全に検索結果から除外したい場合は、noindexメタタグの使用を検討してください。robots.txtはクロールの制御であり、インデックスの制御ではないことを理解しておくことが重要です。

- robots.txtの変更はどのくらいで反映されますか?

-

検索エンジンクローラーは通常24時間に1回程度robots.txtを確認するため、変更が反映されるまでには数時間から1日程度かかることが一般的です。ただし、クロール頻度はサイトの規模や更新頻度によって異なります。重要な変更を行った場合は、Google Search Consoleで確認することをお勧めします。

これらの質問への理解を深めることで、robots.txtをより効果的に活用できるようになります。

まとめ

robots.txtは、SEO対策において重要な役割を果たすファイルです。適切な設定により、検索エンジンクローラーのリソースを効率的に配分し、重要なページの評価向上を図ることができます。

記述方法の理解と設定ミスの回避、定期的なテストによる確認を通じて、robots.txtの効果を最大化することが可能です。SEO戦略の一環として、継続的な見直しと最適化を行っていきましょう。

正しい知識と適切な運用により、robots.txtはサイトの検索エンジン最適化を強力にサポートするツールとなります。今回解説した内容を参考に、あなたのサイトに最適なrobots.txt設定を実現してください。