- AIリスクの4つの主要分野とその具体的な影響

セキュリティ侵害、データプライバシー、判断精度・偏見、法的責任という4つのリスク分野が存在し、それぞれが機密情報漏洩、法的制裁、業務ミス、規制違反などの深刻な影響を企業にもたらす可能性があります。

- 企業が今すぐ実践できる具体的なAIリスク対策方法

技術的セキュリティ対策、データガバナンスの強化、従業員教育、監視体制の構築など、技術面と組織面の両方から包括的にアプローチすることで、効果的なリスク管理が実現できます。

- AIガバナンス体制の構築と法規制への対応戦略

経営層から現場まで明確な役割分担を持つガバナンス体制を構築し、個人情報保護法やEU AI法などの国内外の法規制に適切に対応することで、企業の信頼性維持と持続的成長を実現できます。

AI技術の急速な発展により、多くの企業がAIを業務に導入している一方で、AIリスクについて十分に検討されていないケースが散見されます。AIを活用することで業務効率化や新たな価値創造が期待できる反面、セキュリティ侵害、データ漏洩、偏見による判断ミス、法的責任の所在不明といった様々なリスクも存在します。これらのAIリスクを適切に理解し、具体的な対策を講じることは、企業の持続的成長と信頼性維持のために不可欠です。本記事では、AIリスクの全体像を整理し、企業が今すぐ実践できる効果的な対策方法について詳しく解説します。

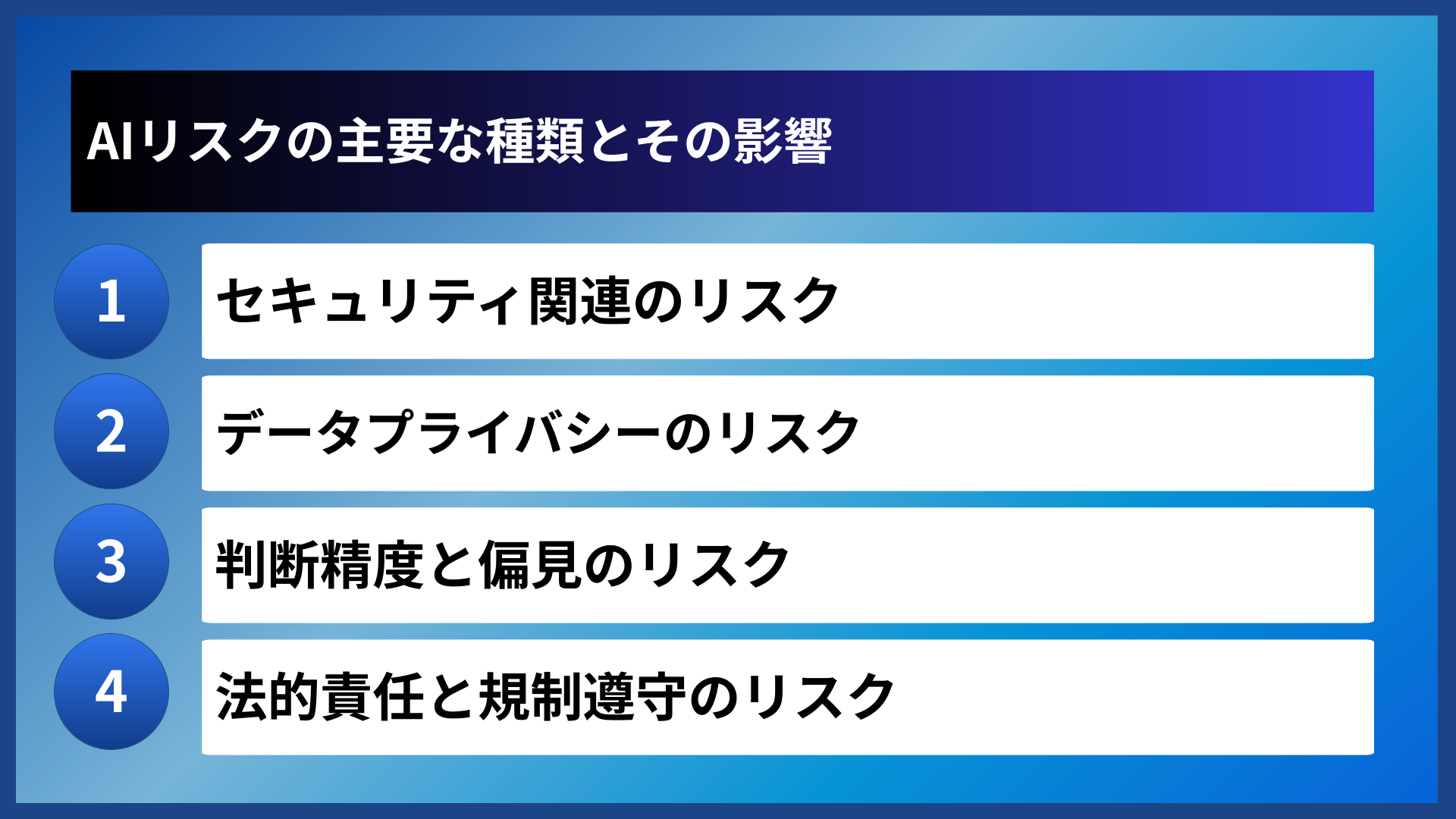

AIリスクの主要な種類とその影響

セキュリティ関連のリスク

AIシステムのセキュリティ脆弱性は、従来のITシステム以上に深刻な被害をもたらす可能性があります。AI学習データの改ざんや不正アクセスにより、システム全体の判断能力が操作される敵対的攻撃が懸念されています。

また、AIモデルから学習データの内容を逆算して取得するモデル反転攻撃や、学習データに含まれる特定の情報を推測するメンバーシップ推論攻撃といった、AI特有のセキュリティリスクも存在します。これらの攻撃により、機密情報の漏洩や個人情報の不正取得が発生する恐れがあります。

データプライバシーのリスク

AIシステムは大量のデータを処理するため、個人情報保護法やGDPRなどの法規制に違反するリスクが高くなります。特に生成AIを利用する際は、入力したデータが学習に使用され、他のユーザーに出力される可能性があることを理解する必要があります。

さらに、AIによる個人データの自動分析により、本来公開されていない個人の属性や嗜好が推測され、プライバシー侵害につながる場合があります。このようなデータプライバシーのリスクは、企業の信頼失墜や法的制裁のリスクを伴います。

判断精度と偏見のリスク

AI技術の判断には必ず誤差が存在し、完全に正確な判断を期待することはできません。特に学習データに偏りがある場合、AIの判断結果にも同様の偏見が反映される可能性があります。

人事採用や融資審査などの重要な判断にAIを活用する際は、性別、年齢、人種などによる不当な差別が生じないよう特に注意が必要です。このような偏見により、企業は社会的責任を果たせないだけでなく、法的リスクも負うことになります。

| リスクの種類 | 主な影響 | 発生頻度 |

|---|---|---|

| セキュリティ侵害 | 機密情報漏洩、システム停止 | 中 |

| データプライバシー | 法的制裁、信頼失墜 | 高 |

| 判断精度・偏見 | 業務ミス、差別問題 | 高 |

| 法的責任 | 訴訟、規制違反 | 中 |

法的責任と規制遵守のリスク

AI技術の急速な発展に対し、法的枠組みの整備が追いついていない現状があります。AIの判断による損害が発生した場合の責任の所在が不明確であることが多く、企業は予期しない法的責任を負うリスクがあります。

また、EU AI法やその他の地域における規制強化の動きもあり、国際的に事業を展開する企業は、複数の法域での規制要件を満たす必要があります。規制の変化に対応できない場合、事業継続に重大な影響を与える可能性があります。

AIリスクは単独で発生するのではなく、複数が連鎖して大きな影響をもたらすことが多いんです。まずはリスクの全体像を把握することが重要ですね。

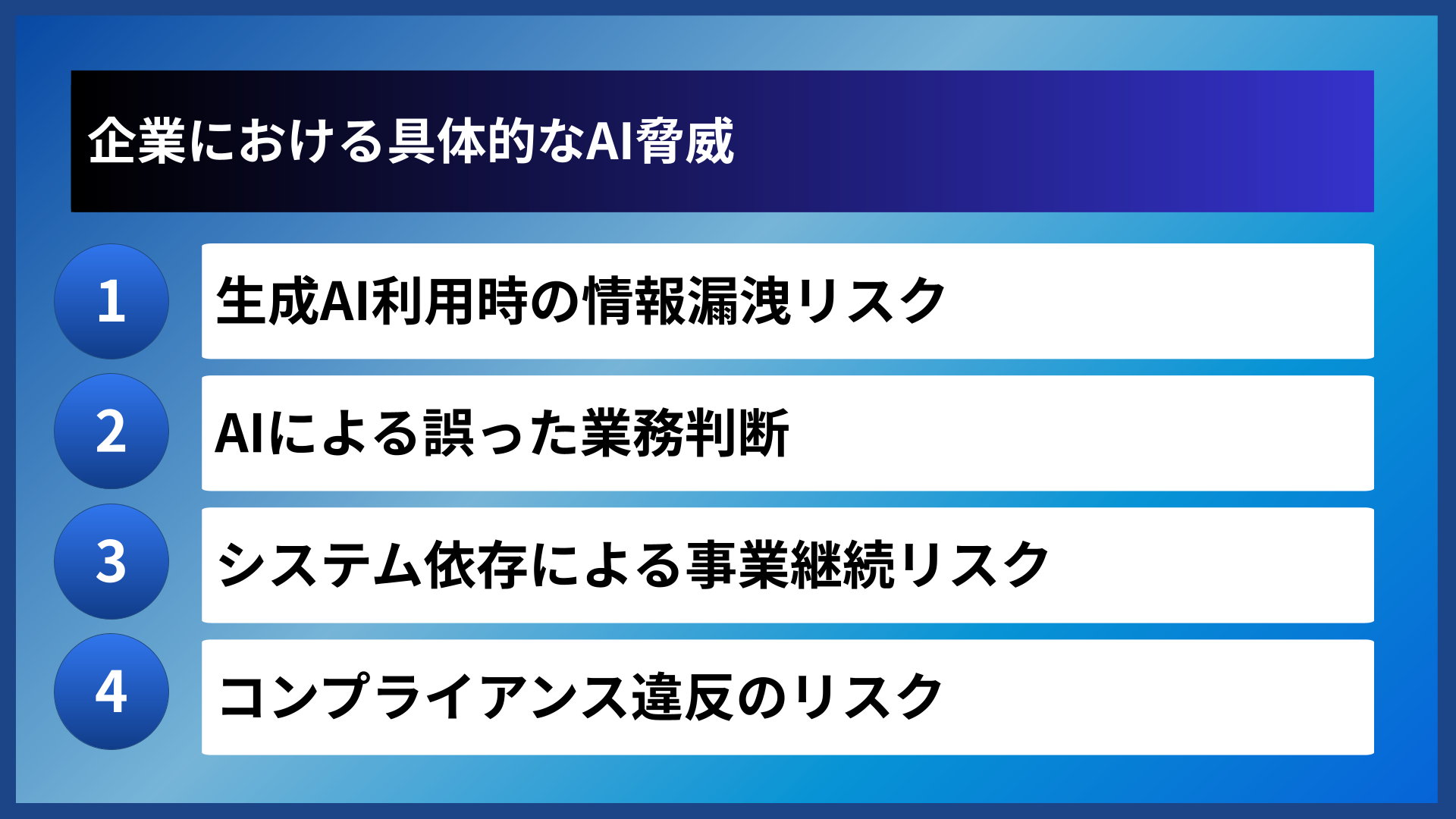

企業における具体的なAI脅威

生成AI利用時の情報漏洩リスク

生成AIサービスの利用において最も深刻な脅威は、機密情報の意図しない漏洩です。ChatGPTやその他の生成AIに業務データを入力した場合、そのデータが学習に使用され、他のユーザーの質問に対する回答として出力される可能性があります。

特に顧客情報、財務データ、開発中の製品情報、戦略資料などを生成AIに入力することは、競合他社への情報漏洩や顧客からの信頼失墜につながるリスクがあります。また、従業員が個人的な利便性のために機密情報を含むデータを無意識に入力してしまうケースも多く報告されています。

AIによる誤った業務判断

AI技術を業務判断に活用する際、システムの判断ミスや偏見により、企業に重大な損失をもたらす可能性があります。財務分析、リスク評価、人事評価などの重要な業務においてAIの判断を過信することは危険です。

AIの判断結果には必ず不確実性が含まれているため、人間による最終確認と検証プロセスを省略してはなりません。また、AIモデルの学習データに含まれる偏見や不完全な情報により、特定の属性を持つ対象に対して不当な判断を下すリスクもあります。

システム依存による事業継続リスク

AI技術への過度な依存により、システム障害や外部サービスの停止時に事業継続が困難になるリスクがあります。クラウド型のAIサービスを利用している場合、サービス提供者の都合により突然サービスが停止されるリスクも考慮する必要があります。

また、AIシステムの判断ロジックがブラックボックス化している場合、システムに異常が発生しても原因の特定や修復が困難になる可能性があります。このような技術的依存は、企業の事業継続計画において重要な検討事項となります。

AI脅威への対策として確認すべきポイント

- 生成AIサービスの利用規約とデータの取り扱い方針を確認する

- 業務でのAI利用ガイドラインを策定し従業員に周知する

- AIシステムの判断結果を検証する仕組みを構築する

- システム障害時の代替手段を準備する

- 定期的なリスク評価とセキュリティ監査を実施する

コンプライアンス違反のリスク

AI技術の活用により、既存の法規制や業界標準への違反リスクが高まる場合があります。個人情報保護、金融規制、医療規制など、業界特有の規制要件とAI活用の間で矛盾が生じる可能性があります。

特に国際的に事業を展開している企業では、各国の規制要件の差異により、一つのAIシステムが複数の法域で異なる法的リスクを抱える場合があります。規制当局からの指導や制裁措置を回避するためには、事前の法的検討と継続的な監視体制が必要です。

| 脅威の種類 | 影響度 | 対策の難易度 |

|---|---|---|

| 情報漏洩 | 高 | 中 |

| 判断ミス | 中 | 高 |

| 事業継続障害 | 高 | 中 |

| コンプライアンス違反 | 高 | 高 |

企業でのAI活用は便利ですが、リスクも現実的に存在します。しっかりとした対策を講じてから活用することが大切でしょう!

バクヤスAI 記事代行では、

高品質な記事を圧倒的なコストパフォーマンスでご提供!

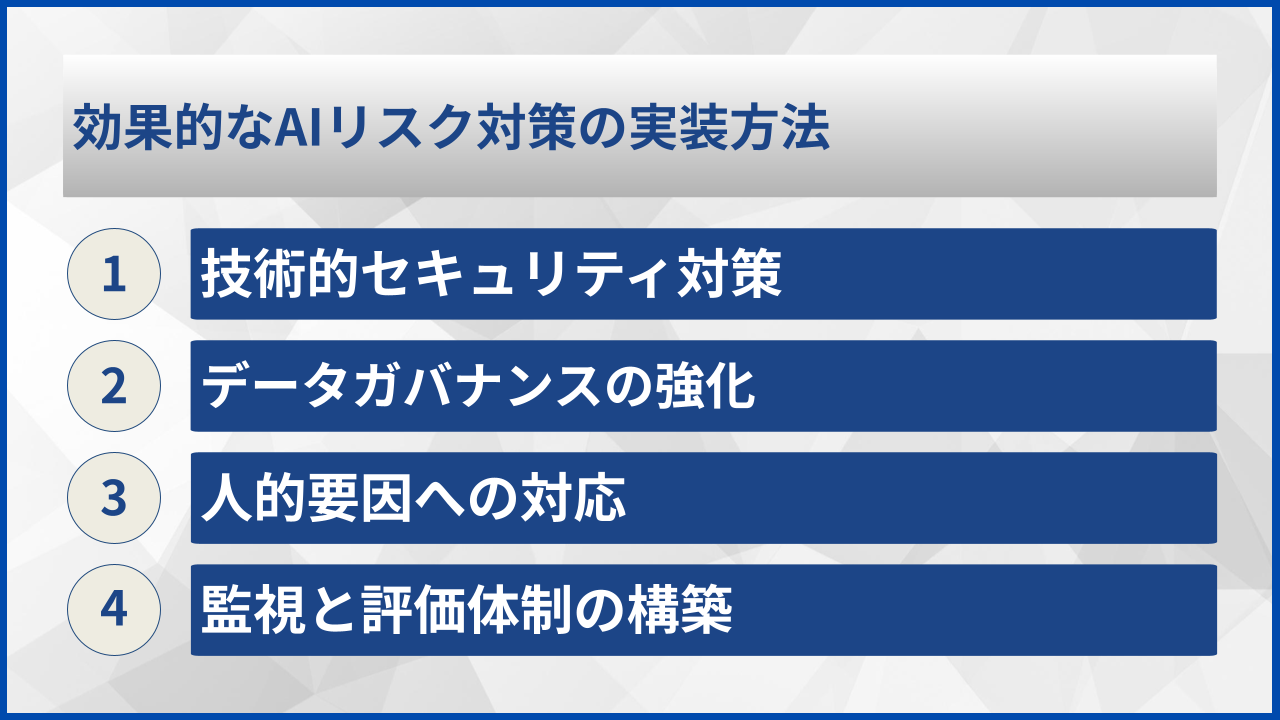

効果的なAIリスク対策の実装方法

技術的セキュリティ対策

AIシステムのセキュリティを確保するためには、従来のITセキュリティに加えて、AI特有の脅威に対応した技術的対策が必要です。まず、AI学習データの暗号化と適切なアクセス制御により、データの機密性を保護します。

また、AIモデルの完全性を保つために、学習済みモデルのデジタル署名や改ざん検知機能の実装が効果的です。敵対的攻撃を防ぐためには、入力データの検証機能や異常検知システムの導入も検討する必要があります。定期的な脆弱性評価とペネトレーションテストにより、システムの安全性を継続的に確認することが重要です。

データガバナンスの強化

AIシステムで使用するデータの品質と適切性を管理するため、包括的なデータガバナンス体制を構築します。データの収集、処理、保存、廃棄に関する明確なポリシーを策定し、全社的に適用します。

個人情報や機密データの取り扱いについては、データ分類制度を導入し、データの重要度に応じた適切な保護レベルを設定することが効果的です。また、データの来歴管理により、AI学習に使用したデータの出所と変更履歴を追跡可能にします。これにより、問題が発生した際の原因究明と対策実施を迅速に行うことができます。

人的要因への対応

AIリスクの多くは人的要因によるものであるため、従業員への教育と意識向上が不可欠です。AI技術の適切な利用方法、禁止事項、リスク認識に関する定期的な研修を実施します。

特に生成AIの業務利用については、機密情報の入力禁止、利用可能な用途の明確化、承認プロセスの確立が重要です。また、AIの判断結果を盲信せず、必ず人間による検証を行う文化を組織内に浸透させる必要があります。

AIリスク対策実装のチェックポイント

- セキュリティポリシーにAI特有の脅威対策を含める

- データ分類制度を導入し適切な保護レベルを設定する

- 従業員向けAI利用研修を定期的に実施する

- AIシステムの監視とログ記録体制を構築する

- インシデント対応手順にAI関連事象を含める

監視と評価体制の構築

AIシステムの運用状況を継続的に監視し、リスクの早期発見と対応を可能にする体制を構築します。AIの判断結果の品質モニタリング、異常検知、性能劣化の検出などを自動化することで、効率的な監視が可能になります。

また、定期的なリスク評価により、新たな脅威や環境変化に対応した対策の見直しを行います。外部の専門機関による第三者評価を活用することで、客観的な視点からのリスク評価も可能になります。これらの監視結果は、経営層への報告と意思決定に活用し、継続的な改善サイクルを確立します。

技術的な対策だけでなく、人と組織の側面からのアプローチが成功の鍵になります。継続的な改善を心がけましょう。

バクヤスAI 記事代行では、高品質な記事を圧倒的なコストパフォーマンスでご提供!

バクヤスAI 記事代行では、SEOの専門知識と豊富な実績を持つ専任担当者が、キーワード選定からAIを活用した記事作成、人の目による品質チェック、効果測定までワンストップでご支援いたします。

ご興味のある方は、ぜひ資料をダウンロードして詳細をご確認ください。

サービス導入事例

株式会社ヤマダデンキ 様

生成AIの活用により、以前よりも幅広いキーワードで、迅速にコンテンツ作成をすることが可能になりました。

親身になって相談に乗ってくれるTechSuiteさんにより、とても助かっております。

▶バクヤスAI 記事代行導入事例を見る

AIガバナンス体制の構築

AIリスク管理組織の設計

効果的なAIガバナンスには、経営層から現場担当者まで、各階層の明確な役割分担が必要です。経営層はAI戦略の方針決定と全社的なリスク許容度の設定を行い、AI責任者はリスク管理の実行と監督を担当します。

現場部門では、日常的なAI利用におけるリスク管理の実践と、問題発生時の迅速な報告を行います。また、法務、IT、人事などの専門部門が連携し、各分野の専門知識をAIリスク管理に活かす体制を構築することが効果的です。定期的な委員会やワーキンググループを通じて、部門間の情報共有と意思決定の迅速化を図ります。

ポリシーと手順の標準化

AIの利用に関する明確なポリシーと標準化された手順の策定により、組織全体で一貫したリスク管理を実現します。AI利用許可基準、データ取り扱いルール、セキュリティ要件、監査手順などを文書化し、全従業員に周知します。

ポリシーは定期的に見直しを行い、技術の進歩や規制の変化に対応して継続的に更新する仕組みが重要です。また、違反時の対応手順や制裁措置を明確に定めることで、ポリシーの実効性を確保します。外部のベストプラクティスや業界標準を参考にしながら、自社の事業特性に適したポリシーを策定することが推奨されます。

| 組織階層 | 主な責任 | 具体的な活動 |

|---|---|---|

| 経営層 | 戦略決定・方針策定 | AI戦略承認、予算承認、リスク許容度設定 |

| AI責任者 | 実行管理・監督 | リスク評価、対策実施、報告・改善 |

| 現場部門 | 日常運用・報告 | ポリシー遵守、インシデント報告、教育参加 |

| 専門部門 | 専門知識提供・支援 | 法的助言、技術支援、監査実施 |

継続的改善プロセス

AIガバナンス体制は一度構築すれば完了するものではなく、環境変化に応じて継続的に改善していく必要があります。定期的なリスク評価、監査結果の分析、インシデントからの学習を通じて、ガバナンス体制の有効性を継続的に検証します。

また、新技術の導入や事業展開に伴い、新たなリスクが発生する可能性があるため、柔軟に対応できる体制を維持することが重要です。外部の専門家や業界団体との連携により、最新の知見や事例を取り入れ、自社のガバナンス体制をより高度なものに発展させていきます。

成果測定と報告体制

AIガバナンスの効果を定量的に測定し、経営層への適切な報告を行う仕組みを構築します。リスク発生件数、対策実施率、従業員の意識度調査結果などの指標により、ガバナンス体制の成果を可視化します。

定期的な報告により、経営層はAIリスク管理の状況を把握し、必要に応じて追加投資や体制強化の判断を行うことができます。また、ステークホルダーへの透明性の高い情報開示により、企業の信頼性向上にも寄与します。

法規制とコンプライアンス対応

現行法制度での注意点

現在の法制度において、AIの活用は個人情報保護法、不正競争防止法、著作権法など、複数の既存法律の適用を受けます。特に個人データを学習に使用するAIシステムでは、データ主体の同意取得、利用目的の明示、データの適正管理が法的に要求されます。

また、AIによる自動判断が消費者に不利益をもたらす場合、消費者契約法や景品表示法の規制対象となる可能性があります。金融業界では金融商品取引法、医療業界では薬機法など、業界特有の規制にも注意が必要です。法的リスクを回避するためには、各法律の要件を詳細に分析し、AI活用方針に反映させることが重要です。

国際規制への対応戦略

EU AI法をはじめとする国際的なAI規制の強化により、グローバル企業はより厳格な対応が求められています。EU AI法では、AIシステムをリスクレベルに応じて分類し、高リスクシステムには厳しい規制を課しています。

国際規制への対応では、最も厳格な規制に合わせたグローバル統一基準を採用することが、効率的かつ確実な方法です。各国の規制要件を個別に対応するよりも、統一された高水準の基準により全社的な対応を図ることで、コストと労力の最適化が可能になります。また、規制当局との継続的なコミュニケーションにより、規制動向の早期把握と適切な対応準備を行います。

| 規制分野 | 主要な法律 | 対応の重要度 |

|---|---|---|

| 個人情報保護 | 個人情報保護法、GDPR | 高 |

| 知的財産 | 著作権法、特許法 | 中 |

| 消費者保護 | 消費者契約法、景表法 | 中 |

| 業界規制 | 金商法、薬機法など | 高 |

コンプライアンス体制の整備

AI関連のコンプライアンスを確実に実行するために、専門チームの設置と定期的な監査体制を構築します。法務部門、コンプライアンス部門、IT部門が連携し、法的要件の変化を迅速に把握し、社内への展開を行います。

また、外部の法律事務所や専門コンサルタントとの連携により、高度な専門知識を補完することも効果的です。定期的なコンプライアンス監査により、社内の遵守状況を客観的に評価し、問題があれば迅速に是正措置を講じます。従業員への法規制教育も継続的に実施し、現場レベルでの適切な判断と行動を促進します。

リスク評価と文書化

法的リスクの適切な管理のために、AIシステムごとの詳細なリスク評価と文書化を実施します。システムの目的、使用データの種類、判断プロセス、影響範囲などを明確に記録し、法的要件との適合性を継続的に確認します。

特に高リスクと判断されるAIシステムについては、より詳細な影響評価と対策の実施を行い、その記録を適切に保管します。これらの文書は、規制当局からの照会や監査において重要な証拠となるため、正確性と完全性を確保することが不可欠です。

法規制は変化が早いので、継続的な情報収集と専門家との連携が成功のポイントです。早めの対応が結果的にコストも抑えられますよ。

よくある質問

AIリスクに関してよく寄せられる質問とその回答をまとめました。企業でのAI活用における実践的な疑問にお答えします。

- AIリスク対策にはどの程度の予算が必要ですか?

-

AIリスク対策の予算は企業規模やAI活用範囲により大きく異なりますが、一般的にはIT予算の10-20%程度を目安とすることが推奨されています。初期投資としてリスク評価、ガバナンス体制構築、従業員研修などに数百万円から数千万円、その後は継続的な監視やアップデートに年間数十万円から数百万円程度が必要と考えられます。ただし、事後的な対応コストを考慮すると、予防的投資の方が結果的に費用効果が高くなることが多いです。

- 中小企業でも実践可能なAIリスク対策はありますか?

-

中小企業でも実践可能な対策として、まず従業員向けのAI利用ガイドライン策定と研修実施から始めることが効果的です。無料または低コストのセキュリティツールを活用し、生成AIサービスの利用規約を詳しく確認して適切なサービスを選択することも重要です。また、業界団体が提供するベストプラクティスや無料のリスク評価ツールを活用し、段階的にリスク管理体制を構築していくことが現実的なアプローチです。

- AI利用時の従業員教育はどのように実施すべきですか?

-

効果的な従業員教育には、定期的な集合研修とオンライン学習の組み合わせが推奨されます。基本的なAIリスクの理解から始まり、具体的な利用シーンでの注意事項、禁止事項、インシデント対応手順までを体系的に教育します。特に実際の業務で使用する可能性の高いツールについては、ハンズオン形式での実践的な研修を行い、理論と実践の両面から理解を深めることが重要です。また、教育効果測定のための理解度テストや、継続的な意識調査も併せて実施することが効果的です。

- AIシステムに障害が発生した場合の対応手順はどうすべきですか?

-

AIシステム障害時の対応手順として、まず影響範囲の特定と緊急停止措置を実施します。次に関係者への迅速な連絡と代替手段での業務継続を図り、原因究明と修復作業を並行して進めます。重要なのは事前に明確なエスカレーション手順と責任者を定めておくことです。また、障害から学んだ教訓を次回の予防策に活かすため、事後分析と改善措置の実施も不可欠です。特にお客様や取引先に影響がある場合は、透明性のある説明と適切な補償措置も検討する必要があります。

これらの質問以外にも、AIリスクに関する疑問や懸念がございましたら、専門家にご相談いただくことをお勧めします。

まとめ

AIリスクは企業の持続的成長を脅かす重要な課題ですが、適切な理解と対策により効果的に管理することが可能です。セキュリティ、プライバシー、判断精度、法的責任の4つの主要リスク分野において、技術的対策と組織的対策を組み合わせた包括的なアプローチが成功の鍵となります。

特に重要なのは、AIガバナンス体制の構築と継続的改善プロセスの確立です。経営層のコミットメントのもと、全社的な取り組みとしてAIリスク管理を制度化し、従業員教育と意識向上を継続的に実施することが不可欠です。

今後も技術の進歩と規制環境の変化により新たなリスクが発生することが予想されるため、柔軟性を持った対応体制を維持し、外部専門家との連携を活用しながら、自社のAIリスク管理能力を継続的に向上させていくことが重要です。適切なリスク管理により、AI技術の恩恵を安全に享受し、競争優位性の確保と企業価値の向上を実現していきましょう。