インターネットで情報を検索する際、私たちは当たり前のように検索エンジンを利用しています。しかし、検索エンジンには「ロボット型」と「ディレクトリ型」という2つの異なる仕組みが存在することをご存じでしょうか。現在主流となっているGoogleやYahoo!はロボット型検索エンジンですが、かつてはディレクトリ型が主流だった時代もありました。本記事では、ロボット型とディレクトリ型検索エンジンの違いについて、それぞれの仕組みや特徴、メリット・デメリットを初心者の方にもわかりやすく徹底解説します。検索エンジンの基本を理解することで、SEO対策やWebマーケティングの知識を深めることができます。

- ロボット型検索エンジンの仕組みと特徴

ロボット型はクローラーが自動でWebサイトを巡回し、膨大な情報をインデックス化して検索結果を表示する仕組みです

- ディレクトリ型検索エンジンの仕組みと特徴

ディレクトリ型は人間の手によってWebサイトを審査・分類し、カテゴリ別に整理された検索システムです

- 両者の違いとSEO対策への影響

現在のSEO対策ではロボット型検索エンジンへの最適化が重要であり、コンテンツの質やサイト構造の改善が効果的です

ロボット型検索エンジンとは

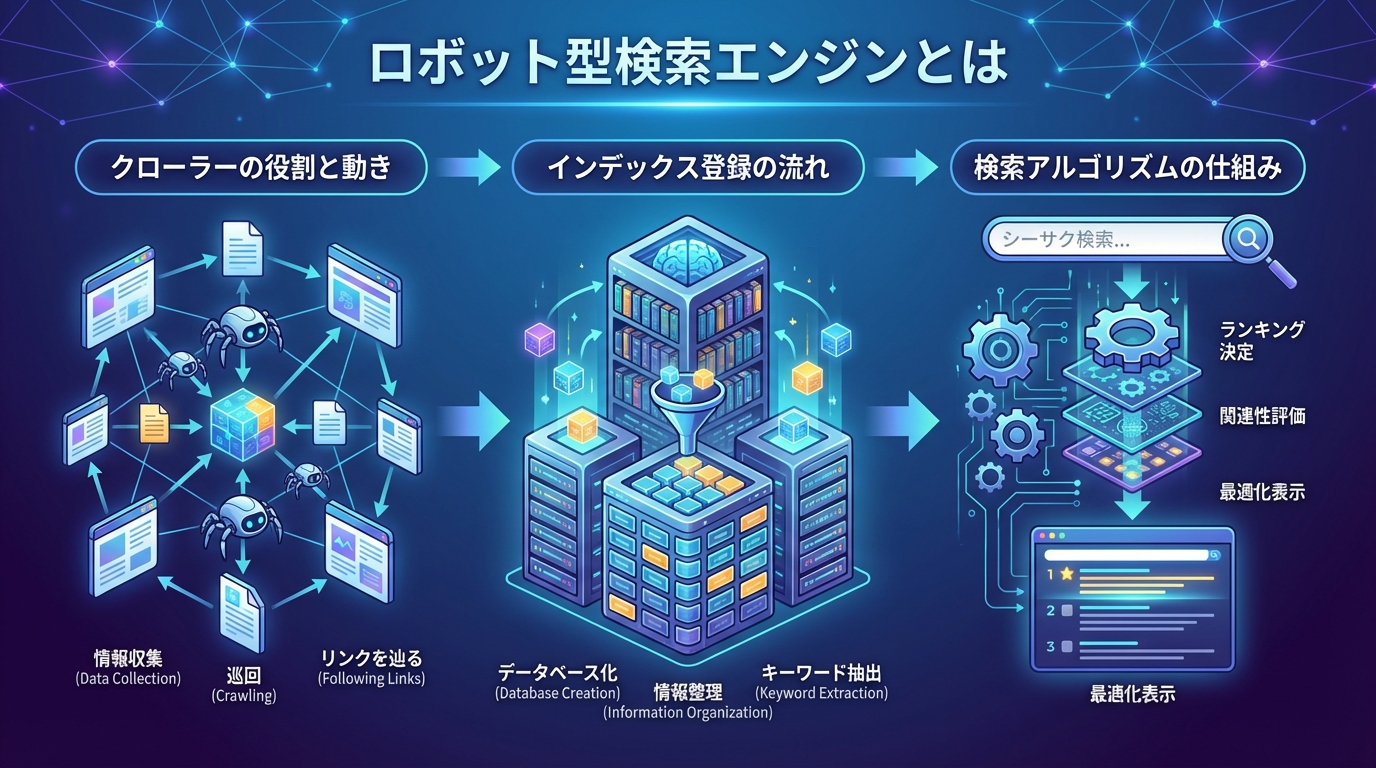

クローラーの役割と動き

クローラーは検索エンジンの「目」として機能し、インターネット上の膨大な情報を自動的に収集する重要なプログラムです。Googleのクローラーは「Googlebot」と呼ばれ、1日に数十億ものページをクロールしているとされています。

クローラーはまず、既知のWebページからリンクをたどって新しいページを発見します。発見したページのHTML構造、テキスト内容、画像の情報、メタデータなどを読み取り、その情報をサーバーに送信します。この作業を休むことなく継続的に行うことで、検索エンジンは常に最新の情報を把握できるようになっています。

インデックス登録の流れ

クローラーが収集した情報は、そのまま検索結果に反映されるわけではありません。収集されたデータは「インデックス登録」というプロセスを経て、検索可能な状態になります。

インデックス登録では、ページの内容が分析され、どのようなキーワードに関連するコンテンツなのかが判断されます。この際、ページの品質や信頼性も評価され、低品質なコンテンツはインデックスから除外されることもあります。

検索アルゴリズムの仕組み

ユーザーが検索クエリを入力すると、検索アルゴリズムがインデックスから最適な結果を選び出します。検索アルゴリズムは、キーワードとの関連性、コンテンツの品質、ページの権威性、ユーザー体験など、200以上の要素を考慮して検索順位を決定しています。

このアルゴリズムは常にアップデートされており、より良い検索結果を提供するために日々改良が続けられています。そのため、SEO対策においてはアルゴリズムの変化に対応し続けることが重要です。

| 要素 | 説明 | 重要度 |

|---|---|---|

| コンテンツの関連性 | 検索キーワードとページ内容の一致度 | 非常に高い |

| ページの権威性 | 被リンク数やドメインの信頼度 | 高い |

| ユーザー体験 | 表示速度やモバイル対応 | 高い |

| コンテンツの鮮度 | 情報の新しさや更新頻度 | 中程度 |

ロボット型検索エンジンは自動化された仕組みで膨大な情報を処理できるため、現在のインターネット環境には欠かせない存在となっています

ディレクトリ型検索エンジンとは

人力による審査の特徴

ディレクトリ型検索エンジンでは、専門の編集者がサイトの品質や信頼性を人の目で確認するため、掲載されるサイトの質が担保されやすいという特徴があります。審査基準には、コンテンツの独自性、情報の正確性、サイトのデザインや使いやすさなどが含まれます。

審査を通過するためには、サイト運営者が登録申請を行い、審査結果を待つ必要がありました。この審査には数週間から数ヶ月かかることもあり、即時性という点ではロボット型に劣る面がありました。

カテゴリ分類の仕組み

ディレクトリ型検索エンジンでは、Webサイトが階層的なカテゴリ構造に沿って整理されます。例えば「ビジネス」「エンターテインメント」「健康」といった大カテゴリの下に、より細分化されたサブカテゴリが設けられています。

ユーザーはカテゴリを順番にたどることで、目的のジャンルに関連するサイトを見つけることができる仕組みになっています。これは図書館の分類システムに似ており、体系的に情報を探したい場合に便利でした。

登録申請のプロセス

ディレクトリ型検索エンジンにサイトを掲載するには、運営者自身が登録申請を行う必要があります。申請時には、サイトのURL、タイトル、説明文、該当するカテゴリなどを記入し、審査を待ちます。

審査では、申請内容と実際のサイト内容の整合性、他の登録サイトとの重複がないか、掲載基準を満たしているかなどがチェックされます。基準を満たさない場合は登録が却下されることもあり、すべてのサイトが掲載されるわけではありませんでした。

ディレクトリ型検索エンジンの特徴を整理すると以下のようになります

- 人間による審査で品質が担保される

- カテゴリ別に整理されており探しやすい

- 登録申請が必要で時間がかかる

- 掲載サイト数に限りがある

ディレクトリ型は品質管理に優れていましたが、インターネットの爆発的な成長に対応しきれず、現在ではほとんど見られなくなっています

バクヤスAI 記事代行では、

高品質な記事を圧倒的なコストパフォーマンスでご提供!

ロボット型とディレクトリ型の違い

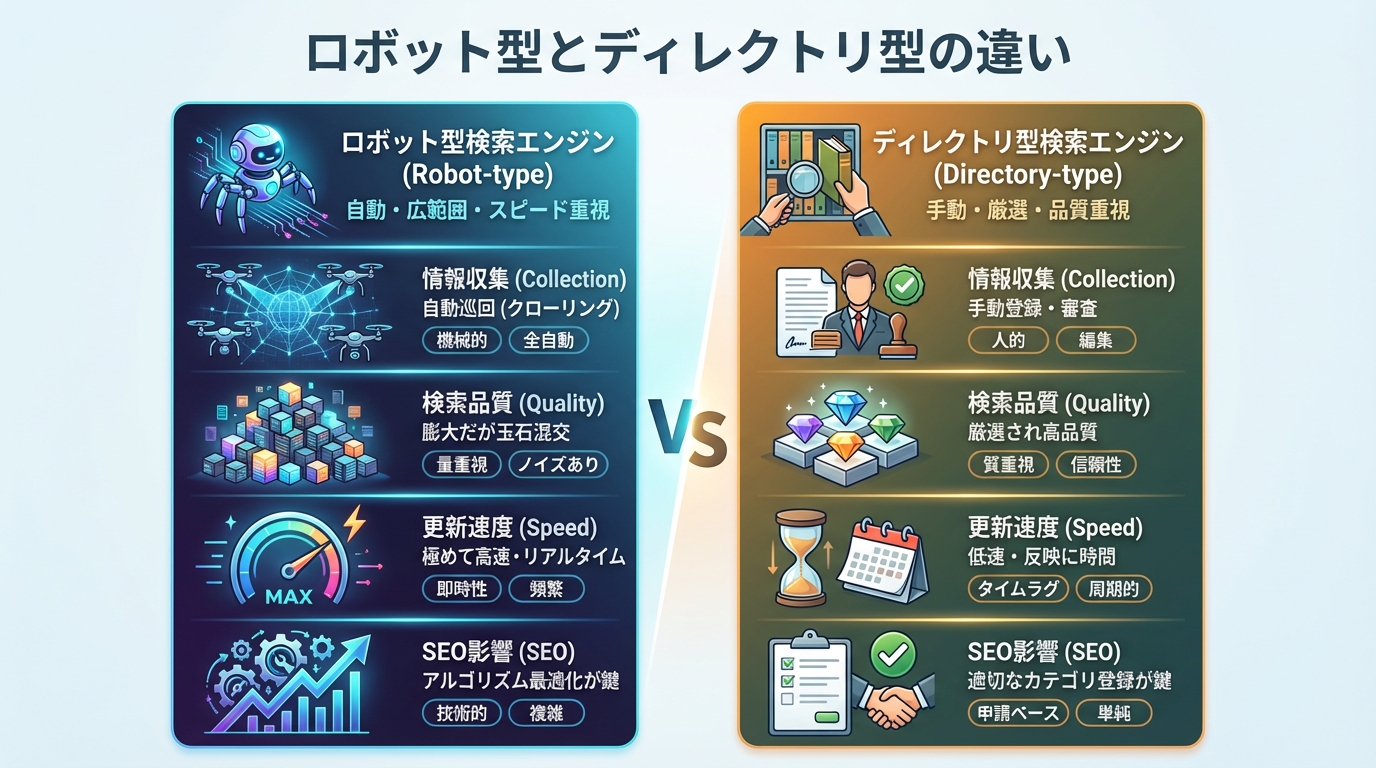

情報収集方法の比較

ロボット型は自動的にWebサイトを巡回して情報を収集するため、膨大な数のページを短時間で処理できるという大きな強みがあります。一方、ディレクトリ型は人間が一つひとつのサイトを確認するため、処理できる量に物理的な限界があります。

この違いは、検索できる情報の範囲に直接影響します。ロボット型では数兆ページ規模のインデックスが構築されていますが、ディレクトリ型では数十万サイト程度が上限でした。インターネット上に存在するWebサイトの数を考えると、網羅性の面でロボット型が圧倒的に優れています。

検索結果の品質の違い

検索結果の品質という観点では、両者にそれぞれ特徴があります。ディレクトリ型は人間が審査しているため、一定水準以上の品質を持つサイトのみが掲載されていました。

ロボット型は自動収集のため、品質の低いサイトも含まれる可能性がありますが、検索アルゴリズムの進化により、現在では高品質なコンテンツが上位表示されるようになっています。Googleのアルゴリズムアップデートは、まさにこの品質評価の精度を高めるために行われています。

更新速度とリアルタイム性

情報の鮮度という点では、ロボット型が大きく優れています。クローラーは継続的にWebサイトを巡回しているため、新しく公開されたページや更新されたコンテンツを比較的早くインデックスに反映できます。

ディレクトリ型では、新しいサイトを掲載するためには登録申請と審査というプロセスが必要でした。この時間的なギャップは、速報性が求められるニュースや最新情報の検索には不向きでした。

| 比較項目 | ロボット型 | ディレクトリ型 |

|---|---|---|

| 情報収集方法 | 自動(クローラー) | 手動(人間による審査) |

| 掲載サイト数 | 数兆ページ規模 | 数十万サイト程度 |

| 更新速度 | 高速(継続的に巡回) | 低速(審査に時間がかかる) |

| 品質管理 | アルゴリズムによる自動判定 | 人間による審査 |

| 登録の必要性 | 不要(自動で検出) | 必要(申請が必要) |

SEO対策への影響

SEO対策の観点から見ると、両者では必要な施策が大きく異なります。ディレクトリ型では、審査に通過することが最も重要でした。そのため、サイトの品質を高め、適切なカテゴリに申請することが主な対策となっていました。

ロボット型では、クローラーにサイトを正しく認識してもらい、検索アルゴリズムで高い評価を得ることが重要です。キーワード最適化、コンテンツの質の向上、内部リンク構造の整備、被リンクの獲得など、多角的なアプローチが求められます。

両者の違いを理解することで、なぜ現在のSEO対策がこのような形になっているのか、その背景がよく分かりますね

バクヤスAI 記事代行では、高品質な記事を圧倒的なコストパフォーマンスでご提供!

バクヤスAI 記事代行では、SEOの専門知識と豊富な実績を持つ専任担当者が、キーワード選定からAIを活用した記事作成、人の目による品質チェック、効果測定までワンストップでご支援いたします。

ご興味のある方は、ぜひ資料をダウンロードして詳細をご確認ください。

サービス導入事例

株式会社ヤマダデンキ 様

生成AIの活用により、以前よりも幅広いキーワードで、迅速にコンテンツ作成をすることが可能になりました。

親身になって相談に乗ってくれるTechSuiteさんにより、とても助かっております。

▶バクヤスAI 記事代行導入事例を見る

ロボット型検索エンジンのメリット

膨大な情報量と網羅性

ロボット型検索エンジンは、インターネット上に存在する数兆ページもの情報を検索対象としているため、あらゆる分野の情報を見つけることができます。マイナーなトピックや専門的な情報でも、どこかにコンテンツが存在すれば検索結果として表示される可能性があります。

この網羅性は、ユーザーにとって非常に便利です。どんな疑問や調べ物であっても、まずは検索エンジンに頼ることができるという安心感があります。ディレクトリ型では、登録されていないサイトは検索結果に表示されないため、このような網羅性は実現できませんでした。

リアルタイムな情報更新

ロボット型検索エンジンは、クローラーが継続的にWebサイトを巡回しているため、新しい情報や更新された内容を比較的早く反映できます。ニュースや速報、トレンド情報など、鮮度が重要な情報を検索する際に非常に有用です。

特にGoogleでは、重要なニュースや話題のトピックについては数分から数時間でインデックスに反映されることもあります。これにより、ユーザーは常に最新の情報にアクセスすることが可能になっています。

無料で利用できる点

ロボット型検索エンジンの多くは、サイト運営者が無料で利用できます。サイトを公開し、クローラーにアクセスできる状態にしておけば、特別な費用をかけずに検索結果に表示される可能性があります。

ディレクトリ型の中には、有料で審査を行うサービスも存在していました。その点、ロボット型では費用をかけずに検索エンジンからの流入を獲得できるため、特に個人サイトや中小企業にとっては大きなメリットとなっています。

ロボット型検索エンジンを活用するためのポイントを確認しましょう

- クローラーがアクセスしやすいサイト構造を作る

- 質の高いコンテンツを継続的に発信する

- 内部リンクを適切に設置する

- 定期的にコンテンツを更新する

ロボット型のメリットを最大限活かすには、クローラーに優しいサイト作りと質の高いコンテンツ制作が重要です

ディレクトリ型検索エンジンのメリット

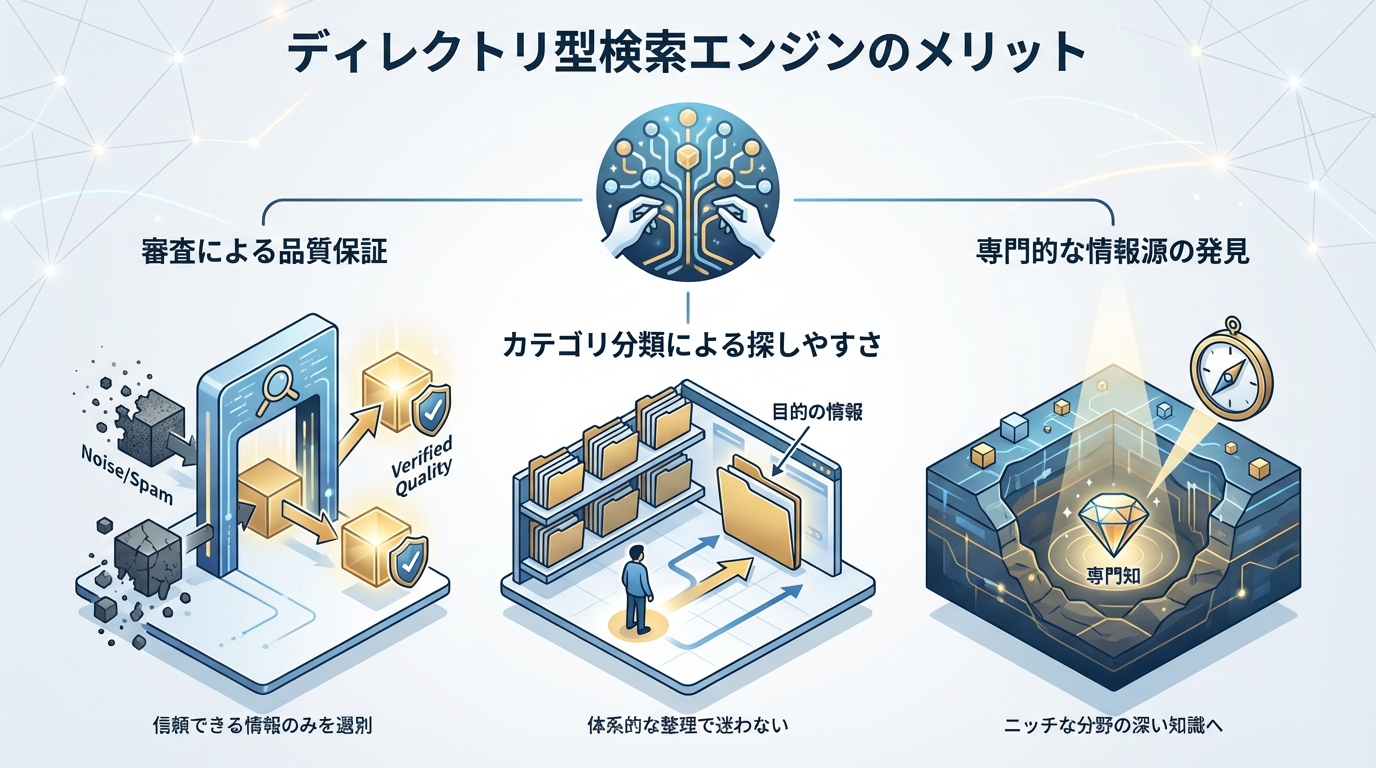

審査による品質保証

ディレクトリ型検索エンジンでは、専門の編集者がサイトを審査するため、スパムサイトや低品質なコンテンツが排除され、信頼性の高い情報源のみが掲載されていました。これは、インターネット黎明期において非常に重要な価値でした。

当時は、検索アルゴリズムの精度が現在ほど高くなかったため、ロボット型検索エンジンでは低品質なサイトが上位表示されることも珍しくありませんでした。その点、ディレクトリ型は人間の目で品質を確認しているため、安心して利用できるという評価がありました。

カテゴリ分類による探しやすさ

ディレクトリ型のもう一つの特徴は、Webサイトが階層的なカテゴリに整理されている点です。例えば「コンピュータ」→「ソフトウェア」→「オフィスソフト」というように、大カテゴリから小カテゴリへとたどることで、関連するサイトを見つけることができました。

この方式は、具体的なキーワードが思いつかない場合や、特定のジャンルのサイトを網羅的に確認したい場合に便利でした。図書館で本を探すように、体系的に情報を探索できる仕組みは一定のユーザーから支持されていました。

専門的な情報源の発見

ディレクトリ型検索エンジンは、特定の分野に特化した専門サイトを見つけるのに適していました。カテゴリを細かく分類することで、ニッチな分野のサイトでも見つけやすくなっていたためです。

また、編集者による推薦やピックアップ機能を持つディレクトリもあり、信頼性の高い情報源を効率的に見つけることができました。このような人間の知見を活かした機能は、ロボット型では実現が難しいものでした。

| メリット | 説明 | 現在の状況 |

|---|---|---|

| 品質保証 | 人間による審査で質を担保 | AIによる品質評価で代替 |

| カテゴリ分類 | 体系的な情報探索が可能 | 検索精度向上で重要性低下 |

| スパム排除 | 悪質サイトの掲載を防止 | アルゴリズムで自動排除 |

ディレクトリ型のメリットは現在のロボット型検索エンジンのアルゴリズム進化により、ある程度補完されるようになっています

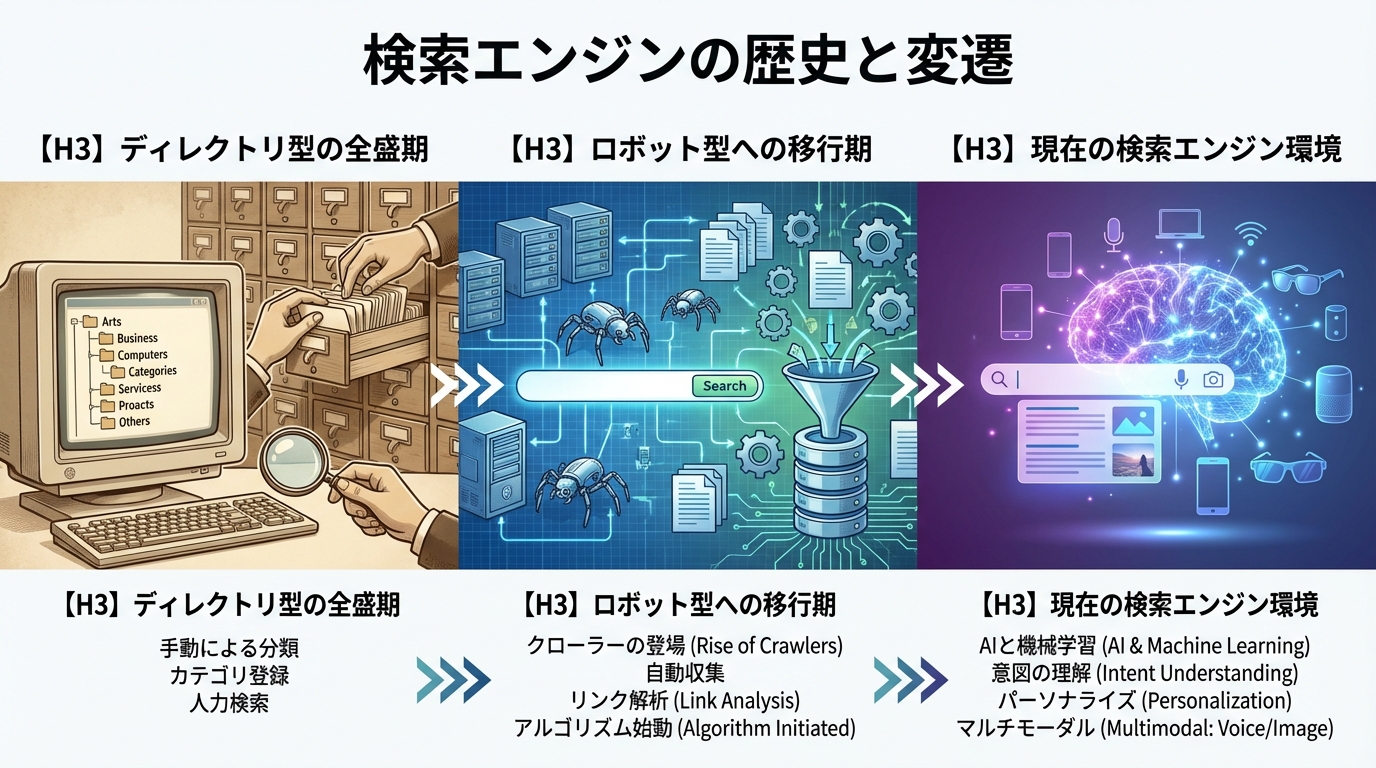

検索エンジンの歴史と変遷

ディレクトリ型の全盛期

1990年代後半から2000年代前半にかけて、Yahoo!カテゴリに代表されるディレクトリ型検索エンジンが広く利用されていました。この時代、インターネット利用者の多くがディレクトリ型を通じて情報を探していました。

Yahoo!カテゴリは日本国内でも大きな影響力を持ち、サイト運営者にとっては登録されることがステータスでもありました。ディレクトリへの登録は、サイトの信頼性を示す一つの指標として認識されていたのです。

ロボット型への移行期

2000年代に入ると、Googleに代表されるロボット型検索エンジンが急速にシェアを伸ばしていきました。その背景には、Web上のコンテンツ量の急増と、検索アルゴリズムの飛躍的な進歩がありました。

特にGoogleのPageRankアルゴリズムは、リンク構造を分析することでページの重要度を自動的に判定する画期的な技術であり、ディレクトリ型を凌駕する検索精度を実現しました。この技術革新が、ロボット型への移行を加速させました。

現在の検索エンジン環境

現在では、Googleが検索エンジン市場で圧倒的なシェアを占めており、ロボット型検索エンジンが完全に主流となっています。Yahoo!カテゴリも2018年にサービスを終了し、ディレクトリ型の時代は事実上終焉を迎えました。

最新の検索エンジンでは、機械学習やAI技術を活用した高度な検索アルゴリズムが採用されています。ユーザーの検索意図を理解し、最も関連性の高い情報を提供するための技術革新が続いています。

検索エンジンの歴史における重要なポイントを確認しましょう

- 1990年代はディレクトリ型が主流だった

- Googleの登場でロボット型が台頭

- 2018年にYahoo!カテゴリが終了

- 現在はAI技術を活用した検索が主流

検索エンジンの歴史を知ることで、SEO対策がなぜ重要なのか、その本質的な理由が見えてきます

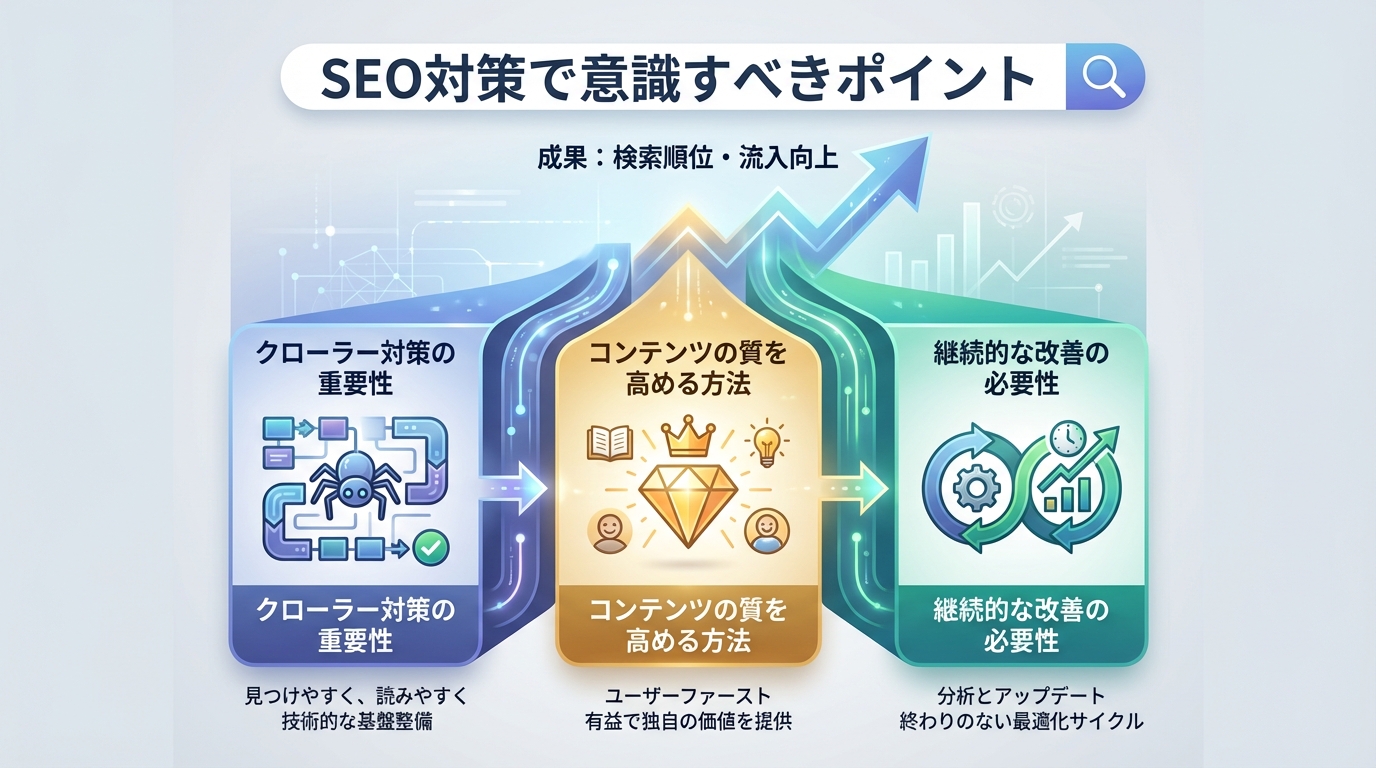

SEO対策で意識すべきポイント

クローラー対策の重要性

ロボット型検索エンジンで上位表示を目指すためには、まずクローラーにサイトを正しく認識してもらうことが前提条件となります。クローラーがアクセスしやすいサイト構造を作ることで、効率的にインデックス登録してもらえます。

具体的には、XMLサイトマップの作成、内部リンクの最適化、ロボットテキストの適切な設定などが挙げられます。これらの技術的な対策を行うことで、クローラーがサイト内のすべてのページを適切に巡回できるようになります。

コンテンツの質を高める方法

検索アルゴリズムは、ユーザーにとって価値のある高品質なコンテンツを高く評価します。そのため、SEO対策においてはコンテンツの質を向上させることが最も重要な施策の一つとなっています。

質の高いコンテンツとは、ユーザーの検索意図に応え、独自の価値を提供し、正確な情報に基づいているものを指します。単にキーワードを詰め込むだけでなく、読者にとって本当に役立つ情報を提供することが求められます。

継続的な改善の必要性

SEO対策は一度行えば終わりというものではありません。検索アルゴリズムは頻繁にアップデートされており、以前は効果的だった施策が無効になったり、新しい評価要素が追加されたりすることがあります。

そのため、検索順位やアクセス状況を定期的にモニタリングし、必要に応じて改善を行っていくことが重要です。また、コンテンツの鮮度も評価要素の一つとなっているため、古い情報は適宜更新することが推奨されます。

| SEO対策の種類 | 具体的な施策 | 期待される効果 |

|---|---|---|

| テクニカルSEO | サイトマップ作成、表示速度改善 | クローラビリティ向上 |

| コンテンツSEO | 質の高い記事作成、キーワード最適化 | 検索順位向上 |

| 外部施策 | 被リンク獲得、SNS活用 | ドメイン権威性向上 |

| ユーザー体験 | モバイル対応、UI改善 | 直帰率低下、滞在時間増加 |

SEO対策は技術面とコンテンツ面の両方を意識しながら、継続的に取り組んでいくことが成功への近道です!

よくある質問

- ロボット型検索エンジンとディレクトリ型検索エンジンの主な違いは何ですか

-

ロボット型はクローラーと呼ばれるプログラムが自動的にWebサイトを巡回して情報を収集します。一方、ディレクトリ型は人間の編集者がサイトを審査し、カテゴリ別に分類して登録する仕組みです。現在は情報量と更新速度の面で優れるロボット型が主流となっています。

- なぜディレクトリ型検索エンジンは衰退したのですか

-

インターネット上のWebサイト数が爆発的に増加したことが主な理由です。人力による審査では処理できるサイト数に限界があり、膨大な情報を網羅できなくなりました。また、ロボット型検索エンジンのアルゴリズムが進化し、品質の高い検索結果を自動で提供できるようになったことも要因の一つです。

- 現在でもディレクトリ型検索エンジンは存在しますか

-

大規模なディレクトリ型検索エンジンはほとんど姿を消しましたが、特定の分野に特化した小規模なディレクトリサービスは一部で存続しています。ただし、主流の検索手段としては完全にロボット型に置き換わっており、日常的な検索ではロボット型を利用することがほとんどです。

- SEO対策はロボット型検索エンジン向けだけを考えればよいですか

-

現在のSEO対策は、実質的にロボット型検索エンジン、特にGoogleを意識したものとなっています。Googleが検索エンジン市場で圧倒的なシェアを持っているため、Googleのアルゴリズムに最適化することが効果的なSEO対策となります。ただし、本質的にはユーザーにとって価値のあるコンテンツを作ることが最も重要です。

まとめ

ロボット型検索エンジンとディレクトリ型検索エンジンは、情報収集の方法において根本的に異なる仕組みを持っています。ロボット型は自動化されたクローラーによる情報収集、ディレクトリ型は人間による審査と分類という対照的なアプローチを取っています。

現在はロボット型検索エンジンが完全に主流となっており、SEO対策もロボット型を前提として行われています。クローラーにサイトを正しく認識してもらうための技術的な対策と、検索アルゴリズムで高い評価を得るためのコンテンツ改善が重要です。

検索エンジンの歴史を理解することで、現在のSEO対策の背景や意義をより深く理解できます。今後もAI技術の進化に伴い、検索エンジンは進化を続けていくことが予想されますので、最新の動向を把握しながら継続的に対策を行っていくことが大切です。