Webサイトを運営していると「Googleクローラーがなかなか来ない」「新しいページがいつまでも検索結果に表示されない」という悩みを抱えることがあります。Googleクローラーとは、Googleがインターネット上のページを発見し、情報を収集するためのプログラムです。このクローラーがサイトを訪問しなければ、どれだけ優れたコンテンツを作成しても検索結果に表示されることはありません。本記事では、Googleクローラーの基本的な仕組みから、巡回頻度を上げるための具体的な最適化テクニック、さらにはクロールを申請する方法まで詳しく解説します。SEO対策の土台となるクローラー対策をマスターして、検索順位の向上を目指しましょう。

- Googleクローラーの種類と役割

Googlebot、Googlebot-Image、AdsBot-Googleなど目的別に複数のクローラーが存在し、それぞれ異なる役割を担っています

- 巡回頻度を上げる4つの最適化テクニック

XMLサイトマップの活用、内部リンク構造の改善、更新頻度の向上、クロールバジェットの最適化が効果的です

- クロールを申請する具体的な方法

Google Search Consoleの「URL検査」機能からインデックス登録をリクエストすることで、クロールを促進できます

Googleクローラーとは

Googleクローラーは、インターネット上に存在する膨大なWebページを自動的に巡回し、情報を収集するプログラムです。別名「スパイダー」や「ボット」とも呼ばれ、検索エンジンの基盤を支える重要な役割を担っています。

クローラーが収集した情報は、Googleのインデックスと呼ばれるデータベースに格納されます。ユーザーが検索窓にキーワードを入力すると、このインデックスから関連性の高いページが抽出され、検索結果として表示される仕組みです。つまり、クローラーに訪問されなければ、そのページは検索結果に表示されることがありません。

クローラーの基本的な役割

Googleクローラーの主な役割は、新しいページの発見と既存ページの更新情報の取得です。クローラーはリンクをたどりながらページからページへと移動し、HTMLコンテンツ、画像、動画などの情報を取得していきます。

取得された情報はGoogleのサーバーに送信され、解析処理が行われます。この解析によって、ページの内容や品質が評価され、最終的に検索結果での順位が決定されます。

クロールからインデックスまでの流れ

クローラーがページを訪問してから検索結果に表示されるまでには、いくつかのステップがあります。まずクローラーがページを発見し、次にページの内容を読み取ってインデックスに登録します。

インデックスに登録されて初めて、そのページは検索結果に表示される資格を得ます。ただし、インデックスされたからといって必ず上位表示されるわけではなく、コンテンツの品質や関連性によって順位が決まります。

以下の表は、クロールからインデックスまでの各ステップをまとめたものです。

| ステップ | 内容 | 所要時間の目安 |

|---|---|---|

| ページ発見 | リンクやサイトマップからURLを検出 | 数時間〜数日 |

| クロール | ページ内容を取得・解析 | 数分〜数時間 |

| インデックス登録 | データベースに情報を格納 | 数時間〜数週間 |

| 検索結果表示 | 検索クエリに応じて表示 | インデックス後すぐ |

この流れを理解することで、SEO対策のどの段階で問題が発生しているかを特定しやすくなります。

主要なクローラーの種類

Googleは目的に応じて複数のクローラーを使い分けています。代表的なものとしては、通常のWeb検索用の「Googlebot」、画像検索用の「Googlebot-Image」、動画検索用の「Googlebot-Video」などがあります。

また、広告関連のチェックを行う「AdsBot-Google」や、モバイル向けサイトをクロールする「Googlebot-Mobile」も存在します。それぞれのクローラーは異なるユーザーエージェントを使用しており、サーバーログを確認することでどのクローラーが訪問したかを識別できます。

Googleクローラーの仕組みを理解することが、効果的なSEO対策の第一歩です。クロールされなければ検索結果に表示されないという基本を押さえておきましょう。

Googleクローラーの種類と特徴

Googleは用途に応じて様々なクローラーとフェッチャーを運用しています。それぞれ異なる役割を持ち、異なるタイミングでサイトを訪問します。自サイトに訪れるクローラーの特徴を把握することで、より効果的な対策が可能になります。

Googleの公式ドキュメントによると、クローラーは大きく分けて「共通クローラー」と「特殊なケースのクローラー」に分類されます。それぞれの特徴を理解し、適切に対応することが重要です。

Googlebotの仕組み

Googlebotは、Google検索で使用されるメインのクローラーです。Web上のページを巡回し、テキストコンテンツやHTMLの構造を解析します。robots.txtの指示に従い、許可されたページのみをクロールします。

Googlebotは現在、JavaScriptのレンダリングにも対応しており、動的に生成されるコンテンツも理解できます。ただし、レンダリングには時間がかかるため、重要なコンテンツはHTML内に直接記述することが推奨されています。

画像と動画のクローラー

Googlebot-Imageは画像検索用のクローラーで、画像ファイルを収集してGoogle画像検索のインデックスを構築します。alt属性や周辺テキストを参考に、画像の内容を理解しようとします。

Googlebot-Videoは動画コンテンツを対象としたクローラーです。動画のサムネイル、再生時間、内容などを解析し、動画検索の結果に反映させます。構造化データを使用することで、より詳細な情報をGoogleに伝えることが可能です。

広告関連のクローラー

AdsBot-Googleは、Google広告のランディングページ品質をチェックするためのクローラーです。広告を出稿しているサイトに対して定期的にアクセスし、ページの品質を評価します。

AdsBot-Googleはrobots.txtでブロックすることができますが、ブロックすると広告の品質評価に影響が出る可能性があります。広告を運用している場合は、このクローラーのアクセスを許可しておくことが望ましいでしょう。

以下の表は、主要なGoogleクローラーの種類と特徴をまとめたものです。

| クローラー名 | 主な用途 | robots.txt対応 |

|---|---|---|

| Googlebot | Web検索全般 | 対応 |

| Googlebot-Image | 画像検索 | 対応 |

| Googlebot-Video | 動画検索 | 対応 |

| AdsBot-Google | 広告品質チェック | 対応 |

| Googlebot-News | ニュース検索 | 対応 |

各クローラーの特性を理解し、必要に応じてrobots.txtで制御することで、効率的なクロールを実現できます。

クローラーには複数の種類があり、それぞれ異なる目的でサイトを訪問します。自サイトに必要なクローラーを把握し、適切に対応することが大切です。

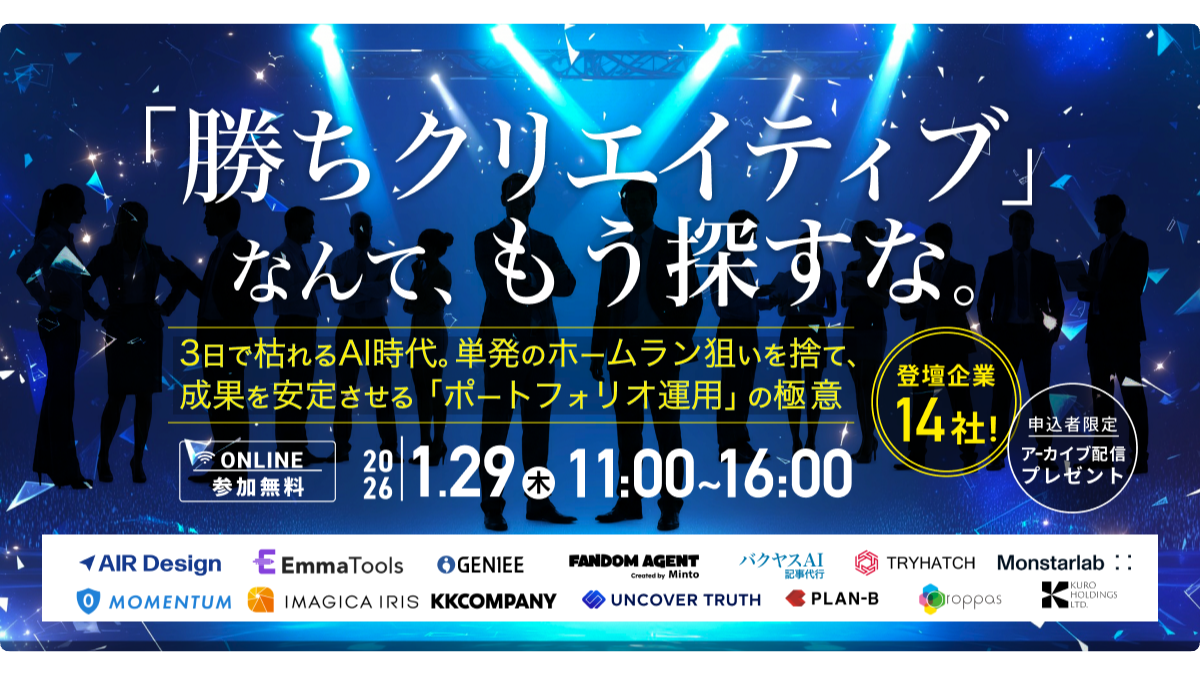

バクヤスAI 記事代行では、

高品質な記事を圧倒的なコストパフォーマンスでご提供!

Googleクローラーの巡回を確認する方法

クローラーが自サイトを適切に巡回しているかどうかを確認することは、SEO対策において非常に重要です。巡回状況を把握することで、問題点を早期に発見し、適切な対策を講じることができます。

確認方法としては、Google Search Consoleを使用する方法と、サーバーログを解析する方法の2つが主に利用されています。それぞれの方法には特徴があり、目的に応じて使い分けることが効果的です。

Search Consoleでの確認手順

Google Search Consoleは、Googleが無料で提供しているWebマスター向けのツールです。クロール統計情報やインデックスステータスを確認することができます。

Search Consoleの「URL検査」機能を使用すると、特定のページがいつクロールされたか、インデックスされているかを即座に確認できます。左メニューから「URL検査」を選択し、確認したいURLを入力するだけで結果が表示されます。

Search Consoleで確認できる主な情報は以下のとおりです。

- 最終クロール日時

- インデックス登録状況

- クロールエラーの有無

- モバイルユーザビリティの問題

クロール統計情報の見方

Search Consoleの「設定」メニューから「クロールの統計情報」を確認することで、サイト全体のクロール傾向を把握できます。日別のクロールリクエスト数やダウンロードサイズ、平均応答時間などが表示されます。

クロールリクエスト数が急激に減少している場合は、robots.txtの設定ミスやサーバーエラーが発生している可能性があります。また、応答時間が長い場合は、サーバーのパフォーマンスに問題があることが考えられます。

サーバーログの解析方法

より詳細な情報を得たい場合は、サーバーのアクセスログを解析する方法が効果的です。ログファイルには、どのクローラーがいつどのページにアクセスしたかが記録されています。

Googlebotのユーザーエージェント文字列で絞り込むことで、Googleクローラーのアクセス履歴のみを抽出することが可能です。これにより、クロール頻度の傾向や、特定のページへのアクセス状況を詳しく分析できます。

以下の表は、主要なGoogleクローラーのユーザーエージェント例です。

| クローラー | ユーザーエージェント例 |

|---|---|

| Googlebot(デスクトップ) | Mozilla/5.0 (compatible; Googlebot/2.1) |

| Googlebot(モバイル) | Mozilla/5.0 (Linux; Android) AppleWebKit Googlebot |

| Googlebot-Image | Googlebot-Image/1.0 |

これらのユーザーエージェントをもとにログを検索することで、各クローラーの動きを追跡できます。

Search Consoleとサーバーログを組み合わせて活用することで、クローラーの巡回状況を詳細に把握できます。定期的な確認を習慣にしましょう。

バクヤスAI 記事代行では、高品質な記事を圧倒的なコストパフォーマンスでご提供!

バクヤスAI 記事代行では、SEOの専門知識と豊富な実績を持つ専任担当者が、キーワード選定からAIを活用した記事作成、人の目による品質チェック、効果測定までワンストップでご支援いたします。

ご興味のある方は、ぜひ資料をダウンロードして詳細をご確認ください。

サービス導入事例

株式会社ヤマダデンキ 様

生成AIの活用により、以前よりも幅広いキーワードで、迅速にコンテンツ作成をすることが可能になりました。

親身になって相談に乗ってくれるTechSuiteさんにより、とても助かっております。

▶バクヤスAI 記事代行導入事例を見る

Googleクローラーへの巡回申請方法

新しいページを公開した際や、既存ページを大幅に更新した際は、Googleクローラーに巡回を申請することで、インデックスまでの時間を短縮できる可能性があります。申請は無料で行うことができ、特別な技術知識も必要ありません。

ただし、申請したからといって必ず即座にクロールされるわけではありません。Googleはサイトの重要度や更新頻度などを考慮して、クロールの優先順位を決定しています。

URL検査ツールの使い方

最も一般的な巡回申請方法は、Google Search Consoleの「URL検査」機能を使用する方法です。Search Consoleにログインし、画面上部の検索窓に対象のURLを入力します。

検査結果が表示されたら「インデックス登録をリクエスト」ボタンをクリックすることで、Googleに巡回を申請できます。この機能を使用すると、通常よりも早くクロールされる可能性が高まります。

インデックス登録をリクエストする際の手順は以下のとおりです。

- Search Consoleにログインする

- URL検査にURLを入力する

- 検査結果を確認する

- 「インデックス登録をリクエスト」をクリックする

サイトマップ送信の手順

複数のページを一括でGoogleに知らせたい場合は、XMLサイトマップを作成してSearch Consoleから送信する方法が効果的です。サイトマップには、サイト内のURLとその更新日時などの情報が含まれています。

Search Consoleの「サイトマップ」メニューから、サイトマップのURLを入力して送信します。送信後は、Googleがサイトマップを読み取り、記載されているURLを順次クロールしていきます。

申請時の注意点

巡回申請には1日あたりの回数制限があります。大量のURLを一度に申請することは避け、重要度の高いページから優先的に申請することが推奨されています。

また、低品質なページや重複コンテンツを含むページを申請しても、インデックスされない場合があります。申請前にページの内容を確認し、ユーザーにとって価値のあるコンテンツであることを確かめましょう。

robots.txtでブロックしているページや、noindexタグが設定されているページは、申請してもインデックスされません。申請前にこれらの設定も確認しておくことが重要です。

巡回申請は便利な機能ですが、万能ではありません。日常的なSEO対策と組み合わせることで、より効果を発揮しますよ。

Googleクローラーの巡回頻度を上げる最適化テクニック

クローラーの巡回頻度を上げることは、新しいコンテンツを素早く検索結果に反映させるために重要です。ここでは、巡回頻度を向上させるための4つの主要な最適化テクニックを詳しく解説します。

これらのテクニックは相互に関連しており、複数を組み合わせて実施することでより大きな効果が期待できます。サイトの規模や特性に応じて、適切な施策を選択してください。

XMLサイトマップの最適化

XMLサイトマップは、サイト内のURL一覧をGoogleに伝えるためのファイルです。適切に設定することで、クローラーがページを発見しやすくなります。

サイトマップには重要なページのみを含め、定期的に更新することが効果的です。エラーページや重複コンテンツを含めると、クロール効率が低下する可能性があります。また、lastmod(最終更新日)を正確に設定することで、更新されたページを優先的にクロールしてもらえます。

内部リンク構造の改善

クローラーはリンクをたどってサイト内を巡回します。そのため、適切な内部リンク構造を構築することで、すべてのページにクローラーが到達しやすくなります。

特に重要なページには、トップページや主要なカテゴリページから直接リンクを張ることが推奨されています。階層が深すぎるページはクローラーに発見されにくくなるため、3クリック以内で到達できる構造を目指しましょう。

コンテンツ更新頻度の向上

定期的にコンテンツを更新しているサイトは、クローラーの訪問頻度が高くなる傾向があります。Googleは、頻繁に更新されるサイトをより重要なサイトと判断するためです。

ブログ記事の投稿や既存ページの更新を定期的に行うことで、クローラーの巡回頻度向上が期待できます。ただし、無意味な更新を繰り返すのではなく、ユーザーにとって価値のある更新を心がけることが大切です。

クロールバジェットの最適化

クロールバジェットとは、Googleがサイトに割り当てるクロールリソースの量のことです。大規模なサイトでは、このバジェットを効率的に使うことが重要になります。

不要なページへのクロールを減らすことで、重要なページにより多くのクロールリソースを振り向けることが可能です。具体的には、パラメータ付きURLの正規化や、重複コンテンツの整理、404エラーページの削減などが効果的な施策となります。

以下の表は、各最適化テクニックの効果と難易度をまとめたものです。

| テクニック | 期待される効果 | 実施難易度 |

|---|---|---|

| XMLサイトマップ最適化 | 高い | 低い |

| 内部リンク構造改善 | 高い | 中程度 |

| 更新頻度向上 | 中程度 | 高い |

| クロールバジェット最適化 | 高い | 高い |

まずは実施難易度の低いXMLサイトマップの最適化から始め、徐々に他の施策に取り組むことをおすすめします。

4つのテクニックを組み合わせることで、クローラーの巡回頻度を効果的に向上させることができます。継続的な改善を心がけましょう!

Googleクローラー対策の注意点

クローラー対策を行う際には、いくつかの注意点があります。誤った設定や過度な最適化は、かえってSEOに悪影響を与える可能性があるため、慎重に対応することが求められます。

特にrobots.txtの設定ミスは、重要なページがインデックスされなくなるという深刻な問題につながることがあります。設定を変更する際は、事前に十分なテストを行うことが重要です。

robots.txtの正しい設定

robots.txtは、クローラーに対してアクセスを許可するページと禁止するページを指示するためのファイルです。正しく設定しないと、意図しないページがブロックされる可能性があります。

robots.txtでブロックしたページはクロールされませんが、他のサイトからリンクされている場合はURLのみがインデックスに登録されることがあります。完全にインデックスを防ぎたい場合は、noindexメタタグを使用する必要があります。

robots.txtを設定する際に確認すべきポイントは以下のとおりです。

- 重要なページをブロックしていないか

- CSSやJavaScriptをブロックしていないか

- サイトマップの場所が正しく記載されているか

- 文法エラーがないか

クロールエラーへの対処

Search Consoleでクロールエラーが報告された場合は、速やかに対処することが重要です。404エラーや500エラーが多発すると、サイト全体の評価に影響する可能性があります。

404エラーの場合は、ページが削除されたのであれば適切なページへ301リダイレクトを設定します。500エラーの場合は、サーバーの問題を調査し、根本的な原因を解決する必要があります。

過度な最適化のリスク

クローラー対策に熱心になりすぎると、過度な最適化になってしまうことがあります。検索エンジンのためだけに作られたページや、不自然なリンク構造は、ペナルティの対象となる可能性があります。

常にユーザーファーストの視点を忘れず、ユーザーにとって価値のあるサイト作りを心がけることが、長期的なSEO成功の鍵です。クローラー対策はあくまでも補助的な施策であり、コンテンツの品質が最も重要であることを忘れないでください。

クローラー対策は正しく行えば効果的ですが、過度な最適化は逆効果になります。バランスを意識して取り組むことが重要です。

よくある質問

- Googleクローラーはどれくらいの頻度でサイトを訪問しますか

-

訪問頻度はサイトによって大きく異なります。ニュースサイトのように頻繁に更新されるサイトは1日に複数回訪問されることがありますが、更新頻度の低いサイトは数週間に1回程度になることもあります。Search Consoleのクロール統計情報で自サイトの訪問頻度を確認できます。

- 巡回申請をしてからインデックスされるまでどれくらいかかりますか

-

数時間から数週間と幅があります。サイトの信頼性や重要度、コンテンツの品質によって所要時間は変わります。新規サイトの場合は時間がかかる傾向があり、既存の信頼性の高いサイトであれば比較的早くインデックスされることが多いです。

- Googleクローラーのアクセスでサーバーに負荷がかかることはありますか

-

通常のクロールでは大きな負荷はかかりませんが、サーバーの処理能力が低い場合や、クロール頻度が非常に高い場合は負荷が発生することがあります。Search Consoleの設定でクロール頻度を調整することも可能です。ただし、頻度を下げるとインデックスまでの時間が長くなる可能性があります。

- robots.txtでクローラーをブロックしたページは検索結果に表示されませんか

-

必ずしもそうとは限りません。robots.txtでブロックされたページは内容がクロールされませんが、他のサイトからリンクされている場合、URLとタイトルのみが検索結果に表示されることがあります。完全に検索結果から除外したい場合は、noindexメタタグを使用してください。

まとめ

Googleクローラーは、Webページを自動的に巡回してGoogleのインデックスに情報を登録するプログラムです。クローラーに訪問されなければ検索結果に表示されないため、SEO対策において非常に重要な存在といえます。

巡回頻度を上げるためには、XMLサイトマップの最適化、内部リンク構造の改善、コンテンツ更新頻度の向上、クロールバジェットの最適化という4つのテクニックが効果的です。これらを組み合わせて実施することで、より大きな効果が期待できます。

クローラーへの巡回申請は、Google Search ConsoleのURL検査機能から簡単に行うことができます。新しいページを公開した際や、大幅な更新を行った際には、積極的に活用しましょう。ただし、過度な最適化は避け、常にユーザーにとって価値のあるコンテンツを提供することを心がけてください。